Tổng quan

Nông nghiệp đang chuyển mình mạnh mẽ nhờ vào công nghệ. Tự động hóa trong sản xuất và thu hoạch đang trở thành xu hướng và là giải pháp tối ưu để nâng cao năng suất. Cánh tay rô–bốt được sử dụng trong thu hoạch cây ăn trái như một mô hình tự động hóa. Tuy vậy, thách thức về tự hành và độ chính xác vẫn là vấn đề lớn cho tính hiệu quả trong hoạt động của cánh tay rô–bốt.

Khoá luận này tập trung vào việc ứng dụng kỹ thuật học sâu tăng cường để cải thiện khả năng tự động của cánh tay rô–bốt trong thu nông nghiệp. Học củng cố sâu, kết hợp học sâu và học tăng cường, cho phép máy móc “học” và “hành động” dựa trên dữ liệu. Điều này mở ra khả năng tự động hóa không chỉ các tác vụ đơn giản mà còn cả hoạt động phức tạp như thu hoạch trái cây.

Nghiên cứu về học củng cố sâu cho thấy tiềm năng lớn trong việc sử dụng mạng nơ– ron sâu để gần đúng các thành phần học củng cố, mở ra ứng dụng mới trong rô–bốt và các lĩnh vực khác của cuộc sống. Deep RL đã trở thành công cụ mạnh mẽ cho phát triển rô–bốt, với các mô hình học sâu giúp rô–bốt hiểu và phản ứng với môi trường, tăng cường tự động hóa và tối ưu hóa.

Trong nghiên cứu, chúng tôi đã phân tích mô hình học sâu tăng cường khác nhau để tìm ra phù hợp cho thu hoạch, đồng thời tối ưu hàm reward để đạt độ chính xác cao. Mục tiêu là phát triển rô–bốt tự động thích nghi với môi trường và thu hoạch hiệu quả. Nghiên cứu góp phần tiến bộ ngành rô–bốt nông nghiệp, mở hướng ứng dụng AI và học máy trong thực tiễn, cải thiện năng suất, giảm chi phí lao động và tăng an toàn sản xuất.

Mục tiêu nghiên cứu

Nghiên cứu và phát triển rô–bốt tự động thu hoạch nông sản, sử dụng phương pháp học tăng cường để hỗ trợ rô–bốt hoạt động chính xác, tự nhiên hơn.

Đối tượng nghiên cứu

- Mô hình học sâu tăng cường

- Điều khiển Rô–bốt qua mạng máy tính

- Trình mô Phỏng Isaac Sim

Phạm vi nghiên cứu

Nghiên cứu mô hình học tăng cường – PPO và A2C cho việc thu hoạch nông sản của cánh tay rô–bốt. Ngoài ra còn cách vận hành trực tiếp từ môi trường ảo ra ngoài thực tế, xây dựng môi trường ảo cho việc mở rộng các tác vụ cho việc huấn luyện DOF rô–bốt.

Mô hình đề xuất

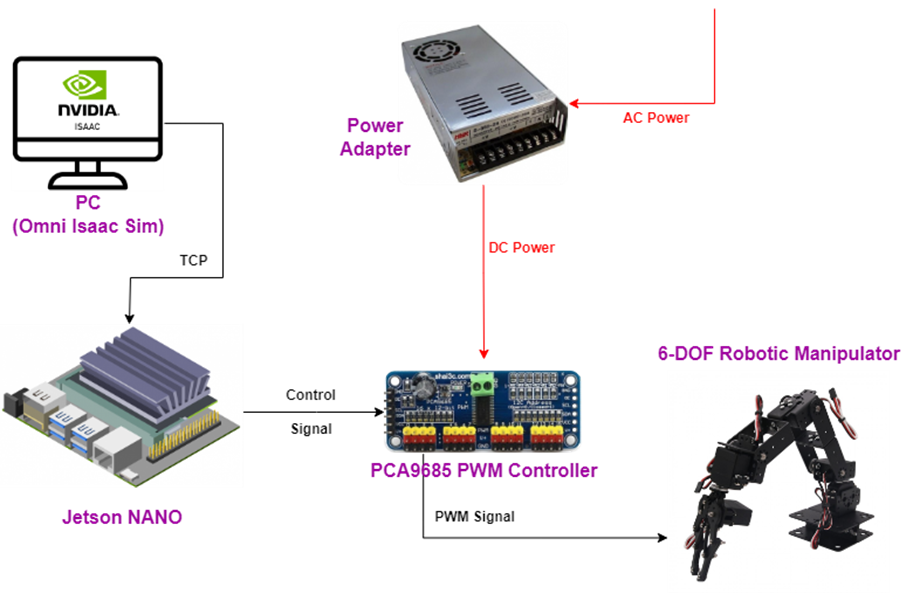

Trong mô hình lần này, chúng tôi sẽ sử dụng một mô hình thiết bị thật Cánh tay rô–bốt 6–DOF, được điều khiển từ phần mềm NVIDIA Isaac Sim thông qua Jetson Nano, và các thiết bị khác theo mô hình như sau:

Tín hiệu điều khiển cánh tay sẽ được gửi từ PC dùng phần mềm NVIDIA Isaac Sim đến Jetson Nano thông qua kết nối TCP trên port 65432.

Mạch PCA9685 được kết nối với Jetson Nano bằng giao thức I2C, để dùng giao thức này chúng ta chỉ cần nối chân SCL và SDA của Jetson Nano với chân tương ứng trên PCA9685. Ngoài 2 chân SCL, SDA, chúng ta còn phải nối lần lượt chân 5V và GND với chân VCC và GND của PCA9685 để có thể cấp nguồn cho mạch PCA9685.

Để điều khiển cánh tay chuyển động, chúng ta sẽ điều khiển trực tiếp các khớp xoay của cánh tay, tức là các động cơ servo. Các động cơ này sẽ được điều khiển trực tiếp bởi NVIDIA Jetson Nano thông qua mạch PCA9685.

Ngoài ra, để có thể cấp đủ nguồn điện cho 6 động cơ servo, ta dùng một bộ nguồn tổ ong. Bộ nguồn này sẽ biến nguồn điện AC 220V – 10A thành dòng điện DC 5.55V – 10A. Dòng điện này sẽ được nối vào chân cấp điện riêng cho servo của mạch PCA9685.

Kết luận

Trong khuôn khổ của khóa luận này, chúng tôi đã trình bày một phương pháp cho việc điều khiển rô–bốt bằng cách sử dụng hai mô hình học sâu tăng cường là PPO và A2C. Phương pháp này kết hợp deep learning trong việc cập nhật chính sách cho mô hình và tạo ra một cấu trúc hoạt động hiệu quả hơn cho mô hình học tăng cường cũng như tăng hiệu quả cho tác vụ đạt tới mục tiêu mà chúng tôi nghiên cứu. Chúng tôi đã tiến hành huấn luyện trên tập dữ liệu là quan sát (vị trí, hướng quay của mục tiêu và DOF rô–bốt) lấy ra từ môi trường của trình mô phỏng Isaac Sim. Cụ thể, đã thành công trong việc áp dụng phương pháp học sâu tăng cường trong việc điều khiển rô– bốt chạm tới mục tiêu trong mô phỏng, và đồng bộ hành vi của mô hình này ra ngoài DOF rô–bốt thật thông qua giao thức TCP. Một phần điều khiển cũng giống như Inverse Kinematics nhưng với học sâu tằng cường, hiệu suất, mức độ tự nhiên trong chuyển động có sự khác biệt rõ rệt. Giải pháp mà chúng tôi giải quyết được vấn đề về lập kế hoạch chuyển động của Rô–bốt trong môi trường mô phỏng cũng như là một minh chứng cho tiềm năng của phương pháp học sâu tăng cường trong việc điều khiển rô–bốt tự hành. Bên cạnh đó, cách thức chúng tôi thực hiện vẫn có rất nhiều hạn chế. Trong chuỗi hành động mà chúng tôi đề xuất, chúng tôi chỉ giải quyết được một vấn đề là đạt đến vị trí chứ chưa có nhiều vấn đề khác.